Deep learning, cabang menarik dari kecerdasan buatan, menawarkan kemampuan mesin untuk belajar dari data kompleks layaknya manusia. Bayangkan mesin yang dapat mengenali wajah Anda dalam keramaian, menerjemahkan bahasa asing secara real-time, atau bahkan mendiagnosis penyakit berdasarkan citra medis – itulah kekuatan deep learning. Konsep intinya terletak pada jaringan saraf tiruan yang berlapis-lapis, memungkinkan pemrosesan informasi yang jauh lebih canggih daripada metode pembelajaran mesin tradisional.

Dari pemahaman dasar arsitektur jaringan saraf hingga penerapannya di berbagai bidang, perjalanan kita akan mengupas algoritma populer seperti CNN, RNN, dan LSTM, serta tantangan yang dihadapi dalam pengembangan dan implementasinya. Kita akan menjelajahi bagaimana deep learning merevolusi berbagai sektor, mulai dari kesehatan hingga keuangan, dan mengungkap potensi serta batasannya di masa depan.

Definisi dan Konsep Dasar Deep Learning

Deep learning, cabang dari machine learning, menggunakan jaringan saraf tiruan (JST) dengan banyak lapisan ( deep) untuk menganalisis data dan mengekstrak fitur-fitur kompleks. Kemampuannya dalam mempelajari pola yang rumit membuatnya unggul dalam berbagai tugas yang sulit dipecahkan oleh metode machine learning konvensional. Perbedaan mendasarnya terletak pada kedalaman dan kompleksitas arsitektur JST yang digunakan.

Perbedaan Deep Learning dan Machine Learning

Meskipun deep learning merupakan bagian dari machine learning, perbedaan utamanya terletak pada bagaimana mereka mempelajari pola data. Machine learning tradisional seringkali membutuhkan fitur-fitur yang diekstrak secara manual oleh manusia, sedangkan deep learning mampu secara otomatis mempelajari fitur-fitur tersebut dari data mentah melalui lapisan-lapisan JST. Ini memungkinkan deep learning untuk menangani data yang lebih kompleks dan berdimensi tinggi dengan lebih efektif.

Arsitektur Dasar Jaringan Saraf Tiruan

Jaringan saraf tiruan dalam deep learning umumnya terdiri dari beberapa lapisan yang saling terhubung. Lapisan-lapisan ini meliputi lapisan input, beberapa lapisan tersembunyi ( hidden layers), dan lapisan output. Setiap lapisan terdiri dari banyak neuron yang saling terhubung melalui bobot ( weights) dan bias ( bias). Proses pembelajaran melibatkan penyesuaian bobot dan bias ini agar JST dapat memetakan input ke output yang diinginkan.

Proses ini dilakukan melalui algoritma optimasi seperti backpropagation.

Contoh Penerapan Deep Learning dalam Kehidupan Sehari-hari

Deep learning telah banyak diterapkan dalam berbagai aspek kehidupan sehari-hari. Beberapa contohnya antara lain: sistem rekomendasi di platform streaming seperti Netflix dan Spotify yang memprediksi preferensi pengguna, pengenalan wajah di ponsel pintar, sistem penerjemahan bahasa otomatis seperti Google Translate, dan mobil otonom yang menggunakan pengolahan citra untuk menavigasi lingkungan sekitar. Penerapannya terus berkembang pesat dan berdampak signifikan pada berbagai industri.

Perbandingan Algoritma Deep Learning

| Algoritma | Jenis Data | Kegunaan | Kelebihan |

|---|---|---|---|

| Convolutional Neural Network (CNN) | Data gambar, video | Pengenalan objek, segmentasi gambar | Efisien dalam memproses data spasial |

| Recurrent Neural Network (RNN) | Data sekuensial (teks, suara) | Pengolahan bahasa alami, sintesis suara | Mampu mengingat informasi dari data sebelumnya |

| Autoencoder | Data berdimensi tinggi | Pengurangan dimensi, deteksi anomali | Dapat mempelajari representasi laten data |

Ilustrasi Jaringan Saraf Tiruan Sederhana

Bayangkan sebuah JST sederhana dengan tiga lapisan: lapisan input, satu lapisan tersembunyi, dan lapisan output. Lapisan input menerima data berupa vektor fitur. Setiap neuron di lapisan tersembunyi menerima input dari semua neuron di lapisan input, melakukan operasi perkalian bobot dan penjumlahan bias, lalu meneruskan hasilnya melalui fungsi aktivasi (misalnya, fungsi sigmoid atau ReLU). Hasil dari lapisan tersembunyi kemudian diteruskan ke lapisan output, yang menghasilkan prediksi.

Setiap koneksi antara neuron memiliki bobot yang dapat diubah selama proses pembelajaran untuk meminimalkan kesalahan prediksi. Lapisan tersembunyi mengekstrak fitur-fitur tingkat tinggi dari data input, sementara lapisan output menghasilkan output akhir. Fungsi aktivasi di setiap neuron menambahkan non-linearitas ke dalam model, memungkinkan JST untuk mempelajari pola yang kompleks.

Algoritma Deep Learning Populer

Deep learning, cabang dari machine learning, memanfaatkan jaringan saraf tiruan dengan banyak lapisan untuk mengekstrak fitur kompleks dari data. Keberhasilannya bergantung pada algoritma yang tepat. Berikut beberapa algoritma deep learning populer dan aplikasinya.

Convolutional Neural Network (CNN) dan Pengolahan Citra

CNN dirancang khusus untuk memproses data dengan struktur grid seperti gambar. Arsitekturnya terdiri dari lapisan konvolusi yang mendeteksi fitur lokal dalam gambar, lapisan pooling yang mengurangi dimensi data, dan lapisan fully connected yang mengklasifikasikan fitur tersebut. Proses konvolusi menggunakan filter (kernel) untuk mendeteksi pola tertentu dalam gambar. Misalnya, filter tertentu dapat mendeteksi tepi, sudut, atau tekstur. Lapisan pooling meringkas informasi dari area lokal, mengurangi kompleksitas komputasi dan meningkatkan ketahanan terhadap perubahan kecil dalam posisi fitur.

Setelah beberapa lapisan konvolusi dan pooling, lapisan fully connected menghasilkan output berupa klasifikasi atau prediksi.

Aplikasi CNN sangat luas dalam pengolahan citra, termasuk klasifikasi gambar (misalnya, mengenali kucing atau anjing), deteksi objek (misalnya, mendeteksi mobil dan pejalan kaki dalam gambar), dan segmentasi gambar (misalnya, memisahkan objek dari latar belakang). Contoh penerapannya antara lain dalam sistem pengenalan wajah, sistem otomasi industri, dan diagnosis medis berbasis citra.

Recurrent Neural Network (RNN) dan Pemrosesan Bahasa Alami

Berbeda dengan CNN, RNN dirancang untuk memproses data sekuensial seperti teks dan suara. RNN memiliki koneksi siklik yang memungkinkan informasi dari langkah waktu sebelumnya untuk memengaruhi langkah waktu saat ini. Hal ini memungkinkan RNN untuk mengingat informasi dari bagian sebelumnya dalam suatu sekuens, yang penting dalam memahami konteks dalam teks atau suara.

Dalam pemrosesan bahasa alami, RNN digunakan untuk berbagai tugas seperti terjemahan mesin, pengenalan ucapan, dan analisis sentimen. Misalnya, dalam terjemahan mesin, RNN dapat memproses kalimat dalam bahasa sumber dan menghasilkan terjemahan yang akurat dalam bahasa target dengan mempertimbangkan konteks seluruh kalimat.

Keunggulan dan Kekurangan Long Short-Term Memory (LSTM)

LSTM merupakan jenis RNN yang dirancang untuk mengatasi masalah vanishing gradient yang sering terjadi pada RNN biasa. Vanishing gradient menyebabkan RNN kesulitan untuk mengingat informasi dari langkah waktu yang jauh sebelumnya. LSTM menggunakan mekanisme gerbang (input gate, forget gate, output gate) untuk mengontrol aliran informasi dalam jaringan, sehingga mampu mengingat informasi jangka panjang dengan lebih efektif.

- Keunggulan LSTM: Dapat menangani dependensi jangka panjang dalam data sekuensial, lebih efektif dalam memproses data sekuensial yang panjang.

- Kekurangan LSTM: Lebih kompleks dan membutuhkan waktu komputasi yang lebih lama dibandingkan RNN biasa.

Contoh Kode Python Sederhana untuk Perceptron Tunggal

Perceptron tunggal merupakan unit dasar dalam jaringan saraf tiruan. Berikut contoh kode Python sederhana untuk implementasi perceptron tunggal:

import numpy as np

def perceptron(x, w, b):

z = np.dot(x, w) + b

return 1 if z > 0 else 0

# Contoh data

x = np.array([0, 1])

w = np.array([0.5, 0.5])

b = -0.7

# Prediksi

y = perceptron(x, w, b)

print(f"Prediksi: y")

Perbandingan Backpropagation dan Gradient Descent

Backpropagation dan gradient descent adalah dua algoritma kunci dalam deep learning untuk melatih jaringan saraf tiruan. Gradient descent merupakan algoritma optimasi yang digunakan untuk menemukan bobot optimal dalam jaringan saraf dengan meminimalkan fungsi kerugian. Backpropagation adalah algoritma yang digunakan untuk menghitung gradien dari fungsi kerugian terhadap bobot dalam jaringan saraf. Dengan kata lain, backpropagation digunakan untuk menghitung arah dan besar perubahan yang harus dilakukan pada bobot agar fungsi kerugian berkurang.

Gradient descent kemudian menggunakan informasi gradien ini untuk memperbarui bobot jaringan saraf.

Backpropagation secara efektif menghitung gradien melalui proses propagasi mundur (backward pass) dari output menuju input. Gradient descent kemudian menggunakan gradien ini untuk memperbarui bobot secara iteratif menuju minimum lokal fungsi kerugian.

Pelajari lebih dalam seputar mekanisme marketing mix di lapangan.

Tantangan dan Pertimbangan dalam Deep Learning

Deep learning, meskipun menawarkan potensi luar biasa, bukanlah solusi ajaib. Prosesnya penuh dengan jebakan dan tantangan yang perlu dipahami dan diatasi untuk mencapai hasil yang optimal. Kesuksesan dalam deep learning bergantung pada banyak faktor, mulai dari kualitas data hingga pemilihan arsitektur model yang tepat. Berikut beberapa tantangan utama yang sering dihadapi.

Overfitting dan Underfitting

Dua masalah klasik dalam pelatihan model deep learning adalah overfitting dan underfitting. Overfitting terjadi ketika model terlalu ‘hafal’ data pelatihan, sehingga performanya buruk pada data baru yang belum pernah dilihatnya. Model terlalu kompleks dan menangkap noise dalam data pelatihan, bukan pola sebenarnya. Sebaliknya, underfitting terjadi ketika model terlalu sederhana untuk menangkap pola kompleks dalam data, sehingga performanya buruk baik pada data pelatihan maupun data uji.

Ini biasanya terjadi ketika model kurang kompleks atau data pelatihan yang terlalu sedikit.

Teknik Regulerisasi untuk Mengatasi Overfitting

Berbagai teknik regulerisasi dapat digunakan untuk mengurangi overfitting. Teknik ini bertujuan untuk menyederhanakan model dan mencegahnya dari menghafal data pelatihan secara berlebihan. Beberapa teknik yang umum digunakan antara lain:

- L1 dan L2 Regularization: Menambahkan penalti pada besarnya bobot dalam model. L1 regularization cenderung menghasilkan beberapa bobot yang bernilai nol, sedangkan L2 regularization menghasilkan bobot yang lebih kecil namun tidak nol.

- Dropout: Secara acak menonaktifkan neuron selama pelatihan, memaksa model untuk belajar representasi yang lebih robust dan kurang bergantung pada neuron individu.

- Early Stopping: Memonitor performa model pada data validasi selama pelatihan dan menghentikan pelatihan ketika performa mulai menurun, mencegah model dari overfitting.

Pentingnya Pengumpulan dan Persiapan Data Berkualitas

Data adalah kunci dalam deep learning. Model yang paling canggih pun akan gagal jika dilatih dengan data yang buruk. Data yang berkualitas harus relevan, akurat, lengkap, dan representatif terhadap masalah yang ingin diselesaikan. Proses persiapan data meliputi pembersihan data (handling missing values, outlier removal), transformasi data (scaling, normalization), dan augmentasi data (untuk meningkatkan jumlah data pelatihan).

Perluas pemahaman Kamu mengenai ar dengan resor yang kami tawarkan.

Langkah-langkah Evaluasi Model Deep Learning

Mengevaluasi performa model deep learning sangat penting untuk memastikan model bekerja dengan baik. Proses evaluasi biasanya melibatkan beberapa langkah:

- Pemilihan Metrik: Memilih metrik yang relevan dengan masalah yang dihadapi, misalnya akurasi, presisi, recall, F1-score, AUC.

- Pembagian Data: Membagi data menjadi data pelatihan, validasi, dan uji. Data validasi digunakan untuk memonitor performa model selama pelatihan, sedangkan data uji digunakan untuk mengevaluasi performa model akhir.

- Cross-Validation: Melakukan pelatihan dan evaluasi model beberapa kali dengan data pelatihan yang berbeda untuk mendapatkan estimasi performa yang lebih robust.

- Analisis Kesalahan: Menganalisis kesalahan yang dibuat oleh model untuk memahami kelemahan model dan memperbaiki model.

Dampak Data Bias pada Hasil Model Deep Learning

Data bias dapat menghasilkan model yang diskriminatif dan tidak adil. Jika data pelatihan merepresentasikan kelompok tertentu secara berlebihan atau merepresentasikan kelompok lain secara kurang memadai, model yang dilatih akan cenderung bias terhadap kelompok yang terwakili secara berlebihan. Contohnya, jika sebuah model pengenalan wajah dilatih dengan data yang sebagian besar terdiri dari gambar wajah orang kulit putih, model tersebut mungkin akan memiliki akurasi yang lebih rendah ketika mengenali wajah orang kulit hitam. Oleh karena itu, penting untuk memastikan data pelatihan yang seimbang dan representatif untuk menghindari bias.

Aplikasi Deep Learning di Berbagai Bidang

Deep learning, subbidang dari machine learning, telah merevolusi berbagai sektor dengan kemampuannya memproses data kompleks dan menemukan pola yang rumit. Kemampuan ini telah menghasilkan aplikasi praktis yang signifikan di berbagai bidang, dari perawatan kesehatan hingga keuangan.

Diagnosa Penyakit dengan Deep Learning

Di bidang medis, deep learning digunakan untuk meningkatkan akurasi dan efisiensi diagnosis penyakit. Algoritma deep learning, khususnya Convolutional Neural Networks (CNNs), dilatih pada kumpulan gambar medis yang besar (seperti X-ray, MRI, dan CT scan) untuk mengidentifikasi pola yang menunjukkan adanya penyakit. Sistem ini dapat mendeteksi kanker, penyakit jantung, dan penyakit mata dengan tingkat akurasi yang menyaingi, bahkan melampaui, para ahli manusia dalam beberapa kasus.

Misalnya, CNN telah terbukti efektif dalam mendeteksi kanker paru-paru pada tahap awal, saat peluang kesembuhan masih tinggi. Kecepatan analisis yang tinggi juga memungkinkan diagnosis yang lebih cepat, yang sangat krusial dalam situasi darurat medis.

Deep Learning dalam Pengembangan Kendaraan Otonom

Kendaraan otonom sangat bergantung pada deep learning untuk menavigasi lingkungan yang kompleks dan dinamis. Sistem ini menggunakan berbagai jenis jaringan saraf, termasuk CNN untuk pengolahan citra, Recurrent Neural Networks (RNN) untuk memprediksi gerakan, dan Reinforcement Learning untuk pengambilan keputusan. CNN memproses data dari sensor kamera untuk mengidentifikasi objek seperti pejalan kaki, kendaraan lain, dan rambu lalu lintas. RNN membantu memprediksi lintasan objek tersebut, sementara Reinforcement Learning memungkinkan kendaraan untuk membuat keputusan navigasi yang optimal, seperti mengubah jalur atau memperlambat kecepatan.

Contohnya, Tesla menggunakan deep learning dalam sistem Autopilot mereka untuk membantu mengemudi dan parkir otomatis.

Sistem Rekomendasi Produk Berbasis Deep Learning

Sistem rekomendasi produk yang efektif sangat penting bagi bisnis e-commerce. Deep learning menawarkan pendekatan canggih untuk personalisasi rekomendasi. Dengan menganalisis riwayat pembelian, preferensi pengguna, dan data demografis, algoritma deep learning dapat menghasilkan rekomendasi yang lebih relevan dan akurat dibandingkan metode tradisional. Model seperti Collaborative Filtering dan Recurrent Neural Networks sering digunakan untuk membangun sistem rekomendasi yang memprediksi preferensi pengguna dengan lebih baik.

Contohnya, Netflix dan Amazon menggunakan deep learning untuk merekomendasikan film dan produk kepada pengguna mereka.

Aplikasi Deep Learning di Sektor Keuangan

Deep learning telah merevolusi berbagai aspek sektor keuangan, dari deteksi penipuan hingga manajemen risiko. Berikut beberapa contoh aplikasinya:

| Aplikasi | Deskripsi | Keuntungan | Contoh |

|---|---|---|---|

| Deteksi Penipuan | Mendeteksi transaksi yang mencurigakan dengan menganalisis pola transaksi yang tidak biasa. | Meningkatkan akurasi dan efisiensi deteksi penipuan. | Bank menggunakan deep learning untuk mendeteksi transaksi kartu kredit yang mencurigakan. |

| Peramalan Pasar Saham | Memprediksi pergerakan harga saham berdasarkan analisis data historis pasar. | Meningkatkan akurasi prediksi dan membantu pengambilan keputusan investasi. | Hedge fund menggunakan deep learning untuk meramalkan harga saham. |

| Manajemen Risiko Kredit | Menilai risiko kredit nasabah dengan menganalisis data keuangan dan demografis. | Meningkatkan akurasi penilaian risiko dan mengurangi kerugian kredit. | Lembaga keuangan menggunakan deep learning untuk menilai risiko kredit peminjam. |

| Robo-Advisor | Memberikan saran investasi yang dipersonalisasi kepada investor berdasarkan profil risiko dan tujuan investasi mereka. | Memberikan akses kepada saran investasi yang terjangkau dan efisien. | Beberapa platform investasi online menggunakan deep learning untuk menyediakan robo-advisor. |

Potensi dan Batasan Deep Learning dalam Keamanan Siber

Deep learning menawarkan potensi besar dalam meningkatkan keamanan siber. Algoritma deep learning dapat digunakan untuk mendeteksi serangan siber yang canggih dan sulit dideteksi dengan metode tradisional. Sistem ini dapat menganalisis lalu lintas jaringan dan mendeteksi anomali yang menunjukkan adanya serangan. Namun, deep learning juga memiliki batasan. Sistem ini membutuhkan data pelatihan yang besar dan berkualitas tinggi untuk mencapai kinerja yang optimal.

Selain itu, sistem deep learning dapat rentan terhadap serangan adversarial, di mana penyerang dapat memanipulasi data masukan untuk menipu sistem.

Pengembangan dan Implementasi Model Deep Learning

Membangun model deep learning bukanlah sekadar menulis kode; itu adalah proses iteratif yang membutuhkan pemahaman mendalam tentang data, arsitektur model, dan teknik optimasi. Dari pengumpulan data hingga penyebaran model yang siap pakai, setiap langkah memerlukan pertimbangan yang cermat. Berikut uraian langkah-langkah kunci dalam pengembangan dan implementasi model deep learning.

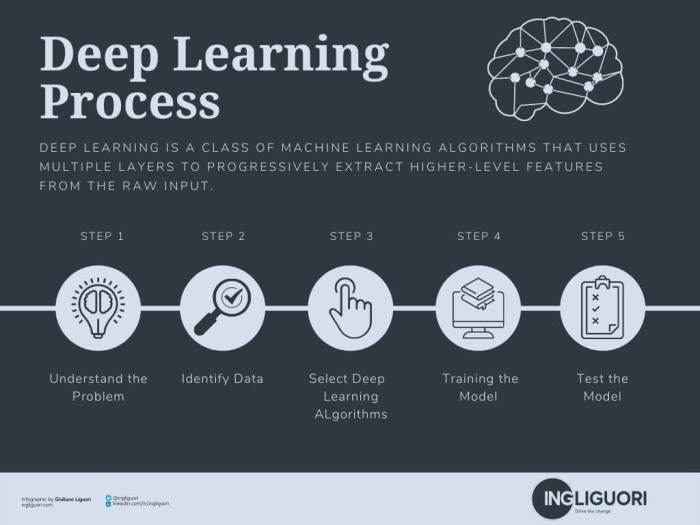

Langkah-langkah Membangun Model Deep Learning

Proses membangun model deep learning umumnya melibatkan beberapa tahapan penting. Tahapan ini saling berkaitan dan keberhasilan di satu tahap akan sangat berpengaruh pada tahap selanjutnya.

- Pengumpulan Data: Tahap awal ini krusial. Data harus relevan, representatif, dan cukup banyak untuk melatih model secara efektif. Kualitas data akan secara langsung memengaruhi performa model.

- Pembersihan dan Prapemrosesan Data: Data mentah seringkali berantakan. Tahap ini melibatkan pembersihan data (menangani nilai yang hilang, outlier, dll.) dan prapemrosesan (misalnya, penskalaan fitur, encoding kategorikal).

- Pemilihan Arsitektur Model: Memilih arsitektur yang tepat (CNN untuk gambar, RNN untuk urutan, Transformer untuk bahasa, dll.) sangat penting. Pilihan ini dipengaruhi oleh jenis data dan masalah yang ingin dipecahkan.

- Pelatihan Model: Model dilatih menggunakan data training. Proses ini melibatkan pengoptimalan bobot dan bias model untuk meminimalkan fungsi kerugian.

- Validasi dan Pengujian Model: Model divalidasi menggunakan data validation untuk memantau kinerja dan mencegah overfitting. Setelah itu, model diuji menggunakan data testing untuk mengukur performanya pada data yang belum pernah dilihat sebelumnya.

- Penyebaran Model: Model yang telah terlatih diimplementasikan ke dalam sistem atau aplikasi yang sebenarnya. Ini bisa berupa deployment ke server, perangkat mobile, atau embedded system.

Perbedaan Training, Validation, dan Testing Set

Ketiga set data ini memiliki peran yang berbeda dan krusial dalam pengembangan model deep learning. Penggunaan yang tepat akan memastikan model terlatih dengan baik dan dapat digeneralisasi dengan baik ke data baru.

- Training Set: Digunakan untuk melatih model. Model belajar pola dan hubungan dari data ini.

- Validation Set: Digunakan untuk memantau kinerja model selama pelatihan dan mencegah overfitting. Dengan melihat performa pada data validasi, kita dapat menghentikan pelatihan sebelum model mulai menghafal data training.

- Testing Set: Digunakan untuk mengukur performa model akhir pada data yang benar-benar baru. Ini memberikan estimasi yang lebih realistis tentang performa model di dunia nyata.

Library dan Framework Deep Learning

Beberapa library dan framework populer memudahkan pengembangan model deep learning. Keunggulan masing-masing framework membuat pilihannya bergantung pada kebutuhan dan preferensi.

- TensorFlow: Framework yang kuat dan serbaguna dari Google, cocok untuk berbagai jenis model dan skala.

- PyTorch: Framework yang fleksibel dan mudah digunakan, populer di kalangan peneliti karena sifatnya yang dinamis.

- Keras: API tingkat tinggi yang dapat berjalan di atas TensorFlow atau lainnya, menyederhanakan proses pengembangan model.

Fine-tuning Model Deep Learning

Fine-tuning adalah teknik untuk memanfaatkan model yang sudah terlatih sebelumnya dan menyesuaikannya dengan dataset yang spesifik. Ini sangat efisien daripada melatih model dari awal, terutama jika dataset terbatas.

- Memilih Model Pra-terlatih: Pilih model yang sesuai dengan tugas dan memiliki arsitektur yang serupa dengan yang dibutuhkan.

- Membekukan Lapisan Awal: Bekukan beberapa lapisan awal model pra-terlatih untuk mempertahankan pengetahuan yang sudah dipelajari.

- Melatih Ulang Lapisan Akhir: Latih ulang lapisan akhir model dengan dataset baru untuk menyesuaikannya dengan tugas spesifik.

- Menyesuaikan Hyperparameter: Sesuaikan hyperparameter seperti learning rate dan jumlah epoch untuk mengoptimalkan kinerja.

Pentingnya Monitoring dan Evaluasi Model

Monitoring dan evaluasi model deep learning secara berkala sangat penting untuk memastikan kinerja yang optimal dan mendeteksi masalah potensial sejak dini. Ini meliputi pemantauan metrik kinerja, distribusi data, dan deteksi drift konseptual. Proses ini memungkinkan penyesuaian dan perbaikan model secara berkelanjutan, memastikan akurasi dan keandalan model dalam jangka panjang.

Deep learning telah dan akan terus membentuk ulang dunia kita. Kemampuannya untuk mengolah data kompleks dan menghasilkan prediksi akurat membuka peluang tak terbatas di berbagai bidang. Meskipun ada tantangan yang perlu diatasi, seperti kebutuhan data besar dan potensi bias, inovasi berkelanjutan dalam algoritma dan teknologi akan terus mendorong perkembangan deep learning menuju solusi yang lebih efisien dan andal.

Perjalanan kita dalam memahami deep learning baru saja dimulai, dan masa depan yang dibentuknya sungguh menjanjikan.